About this mod

Оживи долину Стардью при помощи ИИ диалогов! Общайся с жителями абсолютно на любые темы!

Абсолютно бесплатно используя мощность собственного ПК.

ВНИМАНИЕ!

Требуется больше 8GB VRAM!

- Requirements

- Permissions and credits

Это мой первый мод, который использует мощности вашего ПК и позволяет использовать ИИ абсолютно бесплатно!

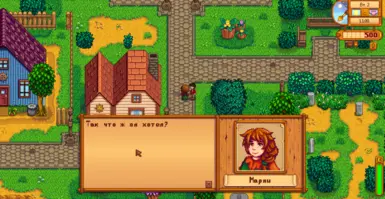

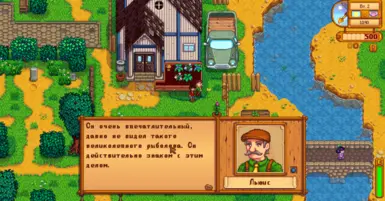

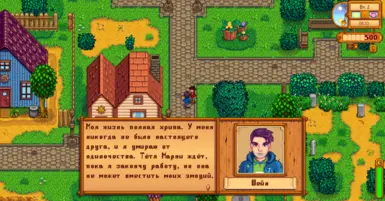

Общайся с жителями долины Стардью абсолютно о чём угодно, мод использует ванильный стиль общения, что добавляет ещё большего погружения!

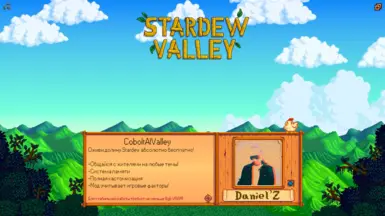

-ИИ учитывает характер и отношения каждого жителя!

-Полностью настраиваемый характер (Файл characters.json)

-Система памяти и связь с ванильными репликами

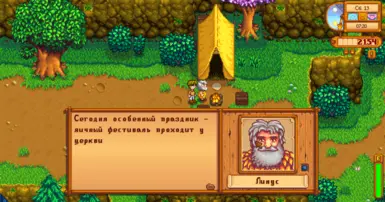

-ИИ может учитывать время и дату

-ИИ учитывает очки дружбы между вами! К примеру если вы только начали играть, он будет считать вас незнакомцем! (Зависит от сердец)

-Динамические отношения (Уровень дружбы меняется в зависимости от тона общения)

-Поддержка кастомных NPC (Инструкция ниже)

(Геймплей зависит от языковых моделей и точной настройки, нужно искать идеальный билд, к примеру одна модель может себя отлично показать, в то время как другая: не понимать смысла вашего текста, неправильно реагировать на инструкции и выводить бессмысленный текст. На данный момент я перебираю различные модели, ниже будут указаны ссылки на хорошие языковые модели).

Мод поддерживает перевод на другие языки! | The mod supports translation into other languages! Check: (events.json, characters.json, config.json and i18n)

Translation: (I am not responsible for the quality of the translation!)

*English - CoboldAIValley [Eng]

ВНИМАНИЕ!

Требуется больше 8GB VRAM!

Программа использует около 6GB оперативной памяти минимум!

Инструкция по установке:

Скачай и установи:

CoboldAIValley - основной мод

SpaceCore

Expanded Preconditions Utility

SMAPI - Stardew Modding API

Generic Mod Config Menu (для настройки мода)

Внешнее ПО (обязательно):

KoboldCpp => Ссылка на гитхаб!

Языковая модель => Есть множество разных моделей, оставлю ссылку на Хабр внутри есть ссылки на неплохие модели и рекомендации по установке.

Ссылка на Хабр

Сайт откуда можно скачать языковые модели: Huggingface.co (Советую использовать для скачивания "Download Master", т.к он имеет возможность докачивать файл)

Внимание! Ниже я укажу хорошие языковые модели, которые тестировал лично!

Размер файлов в сумме составит около: 10ГБ!

1. Устанавливаем основной и дополнительные моды в папку Mods

2. Качаем языковую модель (Тут на ваш вкус, советую модели выше 7B, но не слишком высокие, т.к от этого зависит скорость обработки, с другой стороны, чем выше, тем качественнее будут ответы, тут нужен баланс, где-то около 9B, ниже я укажу ссылки на хорошие модели)

3. Скачиваем CoboldCPP (создайте для него отдельную папку на английском языке (иначе она не запустится)), запускаем от имени администратора и настраиваем его (для быстрой настройки есть опциональный файл)

Либо меняем вручную:

GPU Layers: () (Ниже в статье расскажу как подобрать эту цифру)

Выбрать свою языковую модель: (Browse и устанавливаем скачанную модель) (Ниже в статье рассказано чуть подробнее про модели)

Вкладка Network:

Host: localhost

!Внимание - Если у вас видеокарта AMD, или вы хотите запустить ИИ на процессоре, то Доп. настройки будут ниже!

4. Запускаем и ждём пока консоль загрузит нам ИИ, первый запуск может длиться очень долго от 5 до 20 минут, ничего страшного ждём пока консоль не выдаст адрес - localhost:5001

5. в браузере переходим на localhost:5001 и уверяемся в работоспособности ИИ, а также сбрасываем там конфиг на дефолтный шаблон и ставим режим на chat, консоль не закрываем!

6. (опционально: пошарьте в конфигах мода, можно настроить промт, характеры и т.д)

7. Запускаем игру и смотрим консоль SMAPI, при успешном подключении он скажет что всё ок, при ошибке появится красный текст (если так произошло проверьте порт, его можно изменить как в конфиге, так и в coboldCpp

8. Ура! Подходим к NPC пишем в чат на T текст, игра встанет на паузу и прогрузит ответ NPC в ванильное диалоговое окно.

Если запрос обрабатывается долго, нужно тщательнее настроить CoboldCpp под свой ПК и желательно использовать лёгкие модели

Рекомендация!

Для наилучшего быстродействия используйте лёгкие языковые модели 7B или около (Но учтите, что 7B не очень хорошо справляется с текстом)

Сайт откуда можно скачать языковые модели: Huggingface.co (Советую использовать для скачивания "Download Master", т.к он имеет возможность докачивать файл)

Мой конфиг ПК:

4060ti 8gb

32ГБ озу

xeon 2680 v4 (2.4Gh)

Языковые модели:

!Обратите внимание на число "Q" в названии модели, чем выше "Q" тем больше VRAM она потребляет, тем качественнее генерация текста!

Не устанавливайте модели, где "Q" < 4 !

!Обратите внимание на символ "B", в названии модели, чем выше "B", тем она умнее, тем больше требуется ресурсов ПК и время на генерацию!

Советую скачивать модели .gguf. с числом "B" > 7 и числом "Q" ~4, ~5 или ~6.

Какие модели я тестировал и могу выделить:

Huggingface.co/Harbinger-24B-Q4_K_M.gguf - Модель с 24 миллиардами параметров! Отлично себя показала, хорошо понимает суть диалога, редко ошибается! Моделька потяжелее нижних в списке, но на моём конфиге работает хорошо (В среднем ответ генерирует за 13 секунд, иногда около 20 секунд) (Если у вас 8GB VRAM, в разделе опциональные файлы я сделал оптимизированный конфиг для coboldCpp). Рекомендую!

Huggingface.co/IlyaGusev/saiga_gemma3_12b_gguf - Хорошая лёгкая модель "Q6", показала себя достойно! Учитывает систему памяти, с орфографией бывают ошибки, диалог наполнен смыслом, моделька качественно следует инструкции, у меня генерирует ответ в среднем за 7 секунд. Рекомендую!

Доп. информация по настройке CoboldCPP:

Запускайте кобольд от имени администратора жмите Load и выбирайте пресет настройки (Я выложу свой, но учтите GPU Layers требует настройки под своё кол-во VRAM (желательно), а также в пункте GGUF Text Model: требуется выбрать свою скачанную модель (пример: D:/GPT/Wizard-Vicuna-13B-Uncensored.ggmlv3.q3_K_M.bin) ПУТЬ К ПРОГРАММЕ И ЯЗЫКОВОЙ МОДЕЛИ ДОЛЖЕН БЫТЬ НА АНГЛИЙСКОМ!

1 - CuBLAS = лучшая производительность для графических процессоров NVIDIA

2 - CLBlast = лучшая производительность для графических процессоров AMD

- Для слоёв графического процессора если у вас 8GB VRAM «23», если 16GB и более «43», соответственно если 12GB ставим около «30» . Это количество слоёв графического процессора, которые будет использовать языковая модель, далее "LLM". У разных LLM разное количество максимальных слоёв (7B использует 35 слоёв, 13B использует 43 слоя и т. д.). Если вы обнаружите, что ваш компьютер зависает при генерации ответа ИИ или генерация происходит слишком долго, вы можете уменьшить это значение.

Вкладка Network:

Host: localhost

После чего сохраняйте конфиг (с каждым запуском нужно будет загружать его заново).

Запускаем ИИ!

Ура! Появляется командная строка, ждёте полного запуска (консоль скажет что сервер запущен на localhost:5001 (Или свой порт))

После чего в браузере можно зайти на адрес localhost:5001 и попасть на интерфейс, сбрасываем шаблон до дефолтного и выбираем режим = чат, консоль не закрываем, она должна быть открыта!

Внимание!

Первый запуск может длиться довольно долго, последующие будут намного быстрее

Также есть конфиги:

characters.json: Вы можете редактировать характер и отношения персонажей, также можно добавлять кастомных NPC из других модов;

config.json: Вы можете задать начальный промт, грубо говоря инструкцию, настроить стоп слова (Остальные настройки можно изменить в игре);

events.json: Вы можете отредактировать описание событий, а также добавить день и своё событие к нему (по шаблону);

Мод поддерживает конфиг меню, но промт удобнее задавать в файле!

Если CoboldCpp закрывается: проверьте путь и название папки в которой лежит программа (и языковая модель), оно должно быть на английском языке!

------------------------------------------------------------------------------------------------

Работа с "Стоп словами" и NPC

Как работать с "Стоп-словами"

Если вы заметили, что нейросеть ведёт себя странно, упоминает что-то не понятное или добавляет в диалог 3-е лицо, то:

Скрываем игру и смотрим в консоль coboldCpp, нас интересует Output: (Здесь будет ответ NPC), допустим он пишет:

"Сегодня прекрасный день, жаль завтра будет дождь", "/<br>//" - а мне нравится дождь. assistant: время[], дата[], фестиваль[] и т.д..

Мы видим, что нейросеть пытается продолжить диалоговую линию, нам требуется её остановить, это можно сделать просто добавив "<br>" в конфиг.

Я настроил начальные стоп слова, но у разных моделей свои приколы, какая-то ведёт себя правильно, какая-то может сбиваться, для этого я и ввёл данную функцию!

------------------------------------------------------------------------------------------------

NPC отвечают слишком коротко?

В файле config.json, промт содержит инструкцию которая гласит, чтобы ИИ генерировал ответ не слишком большим, промт можно полностью изменить под себя! (Очень сильно влияет на генерацию!)

P.S Если текст обрезается, в настройках мода увеличь длину символов.

------------------------------------------------------------------------------------------------

NPC перестали вас понимать?

Из-за увеличения промта и доп. деталей программа упирается в предел, из-за чего не может получить ваш диалог!

Посмотри в консоль SMAPI, если ваш промт длиннее 2к символов, консоль сообщит об этом!

Решение! Увеличь в настройках coboldCpp: token size (Раньше я по умолчанию ставил 2к, из-за этого ИИ мог не получить твоё обращение к нему!)

------------------------------------------------------------------------------------------------

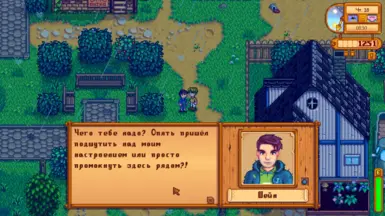

Управление!

Подойдите к NPC, нажмите T (Открыть чат) напишите что хотите сказать, игра просканирует с кем вы говорите (NPC должен стоять рядом) и отправит запрос кобальду, спустя короткий (у кого как) промежуток времени откроется ванильное диалоговое окно

Если вы нажали T и передумали что либо писать, дважды жмите ESC, это закроет меню обращения к NPC.

Повторюсь! Если в игре застыло время при выходе из чата, жмите "ESC" два раза.

Добавляем кастомных NPC и событие для определенного дня!

Для того чтобы добавить кастомного NPC из другого мода: в файлах мода открываем: characters.json, по шаблону добавляем нового NPC - меняем ему имя, характер, связи! (Если вы не знаете, как зовут того или иного NPC, можно глянуть на сайте определенного мода, либо воспользоваться консолью SMAPI: подходим к новому NPC и открываем чат, скрываем игру и разворачиваем SMAPI, находим крайний лог мода: он напишет имя NPC, с которым вы открыли чат).

В файле events.json, можно отредактировать описание текущих событий или добавить своё событие на определенный день! По шаблону добавляем новый день, меняем дату и описание!

Обращение к пользователю:

Спасибо за скачивание, это мой первый мод и я с радостью буду исправлять найденный баги!

На данный момент в мультиплеере мод не работает, но с другими модами конфликтовать не должен!

Если найдёшь серьёзный баг, дай знать, хорошей игры!

Поддержать автора!

---------------------------------------------------------------------------------------------------------------------------------

CoboldAIValley (English)

FeaturesExperience free AI-driven dialogues with Stardew Valley NPCs using your PC's power!

- Character-aware interactions: NPCs remember personalities and relationships

- Customizable traits via characters.json

- Experimental memory system

- Context-aware responses (time, date, friendship levels)

- Vanilla-style dialogue integration

- Custom NPC support (Instructions below)

- Dynamic relationships (Friendship levels change based on your tone)

Required Mods:

SpaceCore

Expanded Preconditions Utility

SMAPI - Stardew Modding API

Generic Mod Config Menu

1.KoboldCpp => Link to GitHub

2. Language Model (gguf) => Huggingface.co

An article that explains well how to run coboldCpp:

Click! nexus

- Requires 8GB+ VRAM!

- Uses ~6GB RAM minimum!

- By default, the mod is in Russian, you need to translate the promt and settings in the files .json

WARNING!

- Install all mods into your mods folder.

- Download a language model.

- Configure KoboldCpp:

- Create an folder for the program.

- Run KoboldCpp as Administrator.

- GPU Layers: Adjust based on your VRAM (see "Optional Settings" below).

- Load your model via Browse

- Network Tab: Set Host to: localhost.

- Launch KoboldCpp. First startup may take 5-20 minutes until the console displays localhost:5001.

- Open localhost:5001 in a browser to verify AI functionality. Reset to default template, select chat

mode, and keep the console open. - (Optional) Tweak prompts/characters in config.json.

- Launch the game. Check SMAPI console for a success message (red text indicates errors—verify port settings).

- Done! Approach an NPC, press T to chat, and watch the AI generate responses in vanilla-style dialogue.

- My specs:

- GPU: RTX 4060 Ti (8GB VRAM)

- RAM: 32GB

- CPU: Xeon 2680 v4 (2.4GHz)

- Prioritize Q4–Q6 quantization (avoid Q < 4).

- Higher B = smarter but heavier (e.g., 24B models need robust hardware).

- Harbinger-24B-Q4_K_M.gguf

- 24B parameters! Understands context well, minimal errors. ~13-20s responses on my setup. Recommended!

- 24B parameters! Understands context well, minimal errors. ~13-20s responses on my setup. Recommended!

- Saiga_Gemma3-12B-Q6.gguf

- Compact yet capable. Follows prompts accurately, ~7s responses. Minor spelling issues. Recommended!

- Compact yet capable. Follows prompts accurately, ~7s responses. Minor spelling issues. Recommended!

- NVIDIA GPUs: Use CuBLAS for best performance.

- AMD GPUs/CPU: Use CLBlast.

- GPU Layers:

- 8GB VRAM → 23 layers

- 12GB VRAM → 30 layers

- 16GB+ VRAM → 43 layers

Troubleshooting

- Strange AI behavior? Check KoboldCpp’s console output. Add unwanted phrases (e.g., <br>) to config.json

’s stop-words list. - Short NPC replies? Edit the prompt in config.json

to encourage longer responses. - NPC misunderstanding you? Increase token size

in KoboldCpp if SMAPI warns about prompt length exceeding 2k characters.

- Custom NPCs: Edit characters.json (add names, traits, relationships). Use SMAPI’s console to identify unknown NPCs.

- Custom Events: Modify events.json to add/change in-game events for specific dates.

- Multiplayer: Not yet supported, but compatible with other mods.

- Bugs? Report issues—I’ll gladly fix them!

- Support the mod: Boosty.to

Slow responses? Try using smaller models!Thxyou!